近日,中科院物理所在江苏省溧阳市举办了“天目杯”理论物理竞赛,并用DeepSeek-R1、GPT-o1和Claude-sonnet三个AI模型对竞赛试题进行了测试。结果显示,DeepSeek-R1表现最佳。

我国“深度求索”公司发布的开源大模型DeepSeek-R1引起了全球关注。在此之前,美国OpenAI公司的GPT-o1、Anthropic公司的Claude以及Google公司的Gemini等模型都声称具备深度思考和推理能力。这些模型在各种测试中表现出色,特别是Google的专用模型AlphaGeometry在国际奥林匹克数学竞赛中取得了28/42的成绩,获得银牌。这引发了人们的好奇,这些强大的AI在物理方面的水平如何。

1月17日,中科院物理所举办了“天目杯”理论物理竞赛。命题组完成了试卷的出题工作,七道题目大部分是原创,旨在考察实际科研中的具体技术问题。竞赛结束后,团队决定测试几个有代表性的AI模型。他们选择了DeepSeek-R1、GPT-o1和Claude-sonnet进行测试。

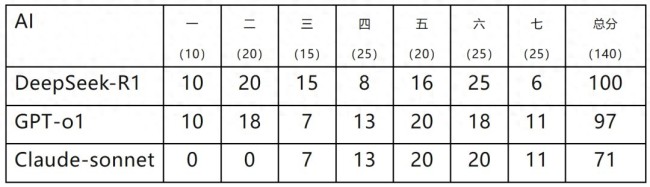

测试过程包括8段对话,首先交代任务和格式要求,然后依次发送题干,每道题目由文字描述和图片描述组成(第三、五、七题无图)。所有模型收到的文字材料相同。阅卷方式与人类选手相同,最终汇总得分。

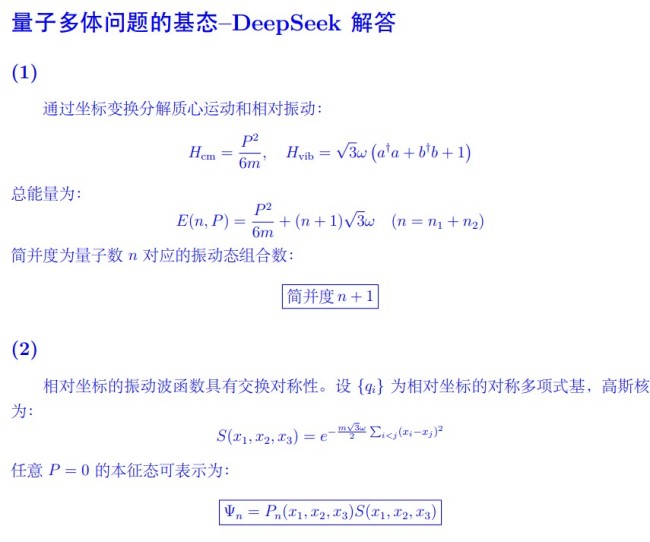

测试结果显示,DeepSeek-R1表现最好,基础题满分,第六题也得到了满分,但在第七题上因未能理解题干中“证明”的含义而失分。GPT-o1总分接近DeepSeek,但有一些计算错误。Claude-sonnet在前两题中得分为零,但后续表现与GPT-o1相近。

如果将AI的成绩与人类成绩相比,DeepSeek-R1可以进入前三名,但与最高分仍有差距;GPT-o1进入前五名,Claude-sonnet则排在前十名。阅卷过程中发现,AI思路清晰,但容易在简单错误中打转,且似乎不完全理解“严密”证明的要求。此外,AI也会出现偶然性错误。

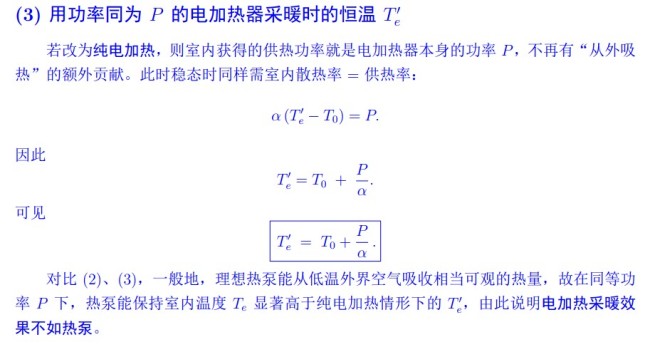

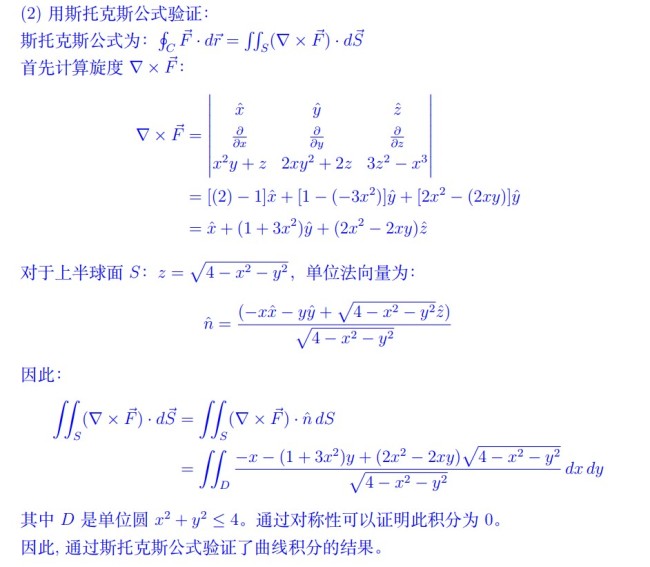

此次竞赛还发布了试题参考答案,希望帮助学生学习并引发进一步思考。